您当前的位置:检测资讯 > 科研开发

嘉峪检测网 2024-11-20 10:24

在 2024 年超级计算机大会上,这家人工智能计算巨头展示了可能是迄今为止最大的人工智能“芯片”——四 GPU Grace Blackwell GB200 NVL4 Superchip,同时宣布其 H200 NVL PCIe 模块已全面上市,可供运行人工智能工作负载的企业服务器使用。

这再次表明该公司正在扩展半导体芯片的传统定义,以推动其 AI 计算雄心。

该产品于周一在超级计算 2024 活动上发布,比 Nvidia 最近推出的 Grace Blackwell GB200 Superchip更进了一步,后者于 3 月作为该公司新的旗舰 AI 计算产品发布。这家 AI 计算巨头还宣布其 H200 NVL PCIe 模块全面上市,这将使今年早些时候推出的 H200 GPU 更适用于标准服务器平台。

Nvidia 加速计算总监 Dion Harris 上周在与记者的简报会上表示,GB200 NVL4 Superchip专为运行高性能计算和 AI 工作负载的“单服务器 Blackwell 解决方案”而设计。

这些服务器解决方案包括惠普企业的 Cray Supercomputing EX154n 加速器刀片,该刀片于上周发布,最多可容纳 224 个 B200 GPU。据 HPE 称,Cray 刀片服务器预计将于 2025 年底上市。

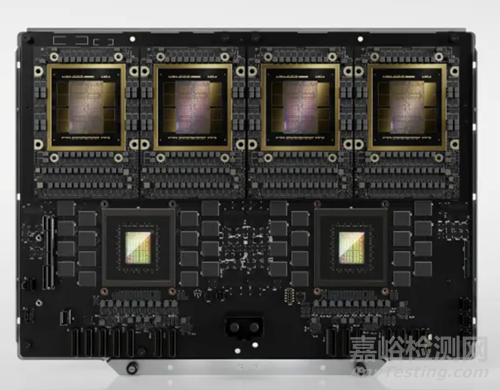

根据 Nvidia 分享的图片显示,GB200 Superchip 看起来就像一块光滑的黑色主板,将一个基于 Arm 的 Grace GPU 与两个基于 Nvidia 新 Blackwell 架构的 B200 GPU 连接起来。而 NVL4 产品似乎将 Superchip 的表面积增加了一倍,在更大的主板上安装了两个 Grace CPU 和四个 B200 GPU。

GB200 Grace Blackwell NVL4 Superchip是标准(非 NVL4)双 GPU 变体的更强大变体,在一个主板上配备了多达四个通过 NVLink 相互连接的B200 Blackwell GPU 和两个基于 Grace ARM 的 CPU。该解决方案旨在处理 HPC 和 AI 混合工作负载,具有高达 1.3TB 的连贯内存。Nvidia 宣传 GB200 NVL4 的模拟性能是其直接前身 Nvidia GH200 NVL4 Grace Hopper Superchip的 2.2 倍,训练性能是其直接前身的 1.8 倍,推理性能是其直接前身的 1.8 倍。

与标准 GB200 Superchip一样,GB200 NVL4 使用 Nvidia 第五代 NVLink 芯片间互连,实现 CPU 和 GPU 之间的高速通信。该公司此前曾表示,这一代 NVLink 可使每个 GPU 的双向吞吐量达到 1.8 TB/s。

Nvidia 表示,GB200 NVL4 Superchip具有 1.3 TB 的一致内存,可通过 NVLink 在四个 B200 GPU 之间共享。

为了展示 GB200 NVL4 的计算能力,该公司将其与之前发布的 GH200 NVL4 Superchip进行了比较,后者最初于一年前作为 Quad GH200 推出,由四个 Grace Hopper GH200 Superchip组成。GH200 Superchip包含一个 Grace CPU 和一个 Hopper H200 GPU。

与 GH200 NVL4 相比,GB200 NVL4 使用 MILC 代码的模拟工作负载速度提高了 2.2 倍,训练 3700 万参数的 GraphCast 天气预报 AI 模型的速度提高了 80%,使用 16 位浮点精度对 70 亿参数的 Llama 2 模型进行推理的速度提高了 80%。

该公司没有提供任何进一步的规格或性能声明。

哈里斯在与记者的简报中表示,Nvidia 的合作伙伴预计将在本周的 2024 年超级计算大会上推出基于 Blackwell 的全新解决方案。

他说道:“得益于参考架构,Blackwell 的推出进展顺利,使合作伙伴能够快速将产品推向市场,同时添加自己的定制功能。”

Nvidia发布H200 NVL PCIe模块

除了发布 GB200 NVL4 Superchip外,Nvidia 还宣布其之前发布的 H200 NVL PCIe 卡将于下个月在合作伙伴系统中推出。

NVL4 模块包含 Nvidia 的 H200 GPU,该 GPU 于今年早些时候以 SXM 外形尺寸推出,适用于 Nvidia 的 DGX 系统以及服务器供应商的 HGX 系统。H200 是该公司 H100 的后继产品,使用相同的 Hopper 架构,并帮助 Nvidia 成为生成 AI 工作负载 AI 芯片的主要提供商。

与标准 PCIe 设计不同的是,H200 NVL 由两张或四张 PCIe 卡组成,这些卡使用 Nvidia 的 NVLink 互连桥连接在一起,使每个 GPU 的双向吞吐量达到 900 GB/s。该产品的前身 H100 NVL 仅通过 NVLink 连接两张卡。

与带有液体冷却选项的 H200 SXM 相比,它也采用风冷。

哈里斯表示,双槽 PCIe 外形尺寸使 H200 NVL“成为具有低功耗、风冷企业机架设计的数据中心的理想选择,具有灵活的配置,可为每个 AI 和 HPC 工作负载提供加速,无论其规模大小”。

他说:“公司可以使用现有的机架,选择最适合其需求的 GPU 数量,从 1、2、4 甚至 8 个 GPU 中选择,NVLink 域可扩展到 4 个。”“企业可以使用 H200 NVL 来加速 AI 和 HPC 应用,同时通过降低功耗来提高能源效率。”

与其 SXM 同类产品一样,H200 NVL 配备 141GB 高带宽内存和 4.8 TB/s 内存带宽,而 H100 NVL 的容量为 94 GB 和 3.9 TB/s,但其最大热设计功率仅为 600 瓦,而不是 H200 SXM 版本的最大 700 瓦,据该公司称。

这导致 H200 NVL 的性能略低于 SXM 模块。例如,H200 NVL 只能达到 64 位浮点 (FP64) 30 万亿次浮点运算和 8 位整数 (INT8) 3,341 万亿次浮点运算,而 SXM 版本可以达到 FP64 34 万亿次浮点运算和 INT8 3,958 万亿次浮点运算。(万亿次浮点运算是每秒一万亿次浮点运算的计量单位。)

Nvidia 表示,在对 700 亿参数的 Llama 3 模型进行推理时,H200 NVL 比 H100 NVL 快 70%。至于 HPC 工作负载,该公司表示 H200 NVL 在逆时迁移建模方面快 30%。

H200 NVL 附带 Nvidia AI Enterprise 软件平台的五年订阅,该平台配备 Nvidia NIM 微服务,可加速 AI 开发。

参考链接

https://www.crn.com/news/components-peripherals/2024/nvidia-reveals-4-gpu-gb200-nvl4-superchip-releases-h200-nvl-module

来源:内容编译自crn